![4. Überlegungen zur Konvergenz der Spielbrettmethode Nicht alle im Rahmen dieser Facharbeit untersuchten Spielszenarien führen schnell zu Ergebnissen. Das „Crap-Spiel” ([1], S. 36, Aufgabe 17) erfordert z.B. 54-maliges Nachladen des Startzustandes ... 4. Überlegungen zur Konvergenz der Spielbrettmethode Nicht alle im Rahmen dieser Facharbeit untersuchten Spielszenarien führen schnell zu Ergebnissen. Das „Crap-Spiel” ([1], S. 36, Aufgabe 17) erfordert z.B. 54-maliges Nachladen des Startzustandes ...](http://www.gerneth.com/markov/docs/bild-4.1.jpg)

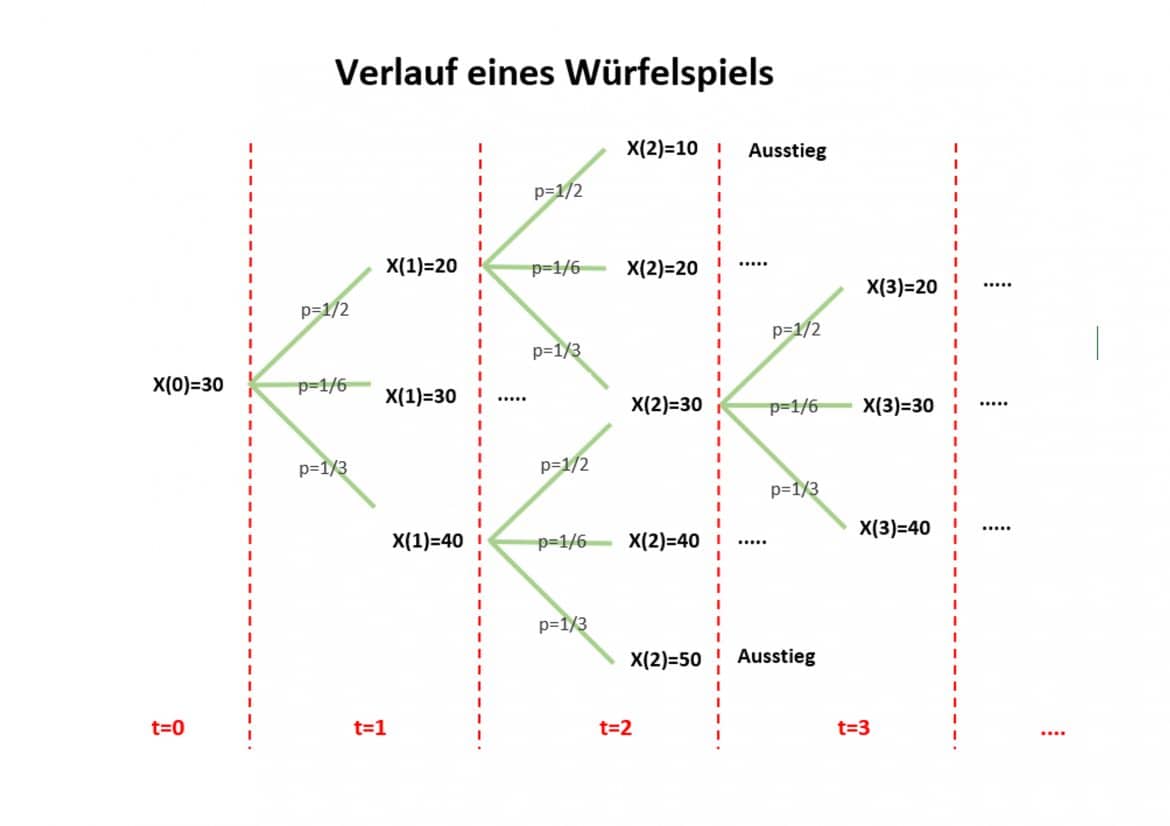

4. Überlegungen zur Konvergenz der Spielbrettmethode Nicht alle im Rahmen dieser Facharbeit untersuchten Spielszenarien führen schnell zu Ergebnissen. Das „Crap-Spiel” ([1], S. 36, Aufgabe 17) erfordert z.B. 54-maliges Nachladen des Startzustandes ...

Absorptionswahrscheinlichkeiten, Markow-Kette, Markov-Kette, Markoff-Kette | Mathe by Daniel Jung - YouTube